Google logra que la IA reconozca el lesco (lenguaje por señas) por máquinas

La capacidad de percibir la forma y el movimiento de las manos puede ser un componente vital para mejorar la experiencia del usuario en una variedad de dominios y plataformas tecnológicas. Por ejemplo, puede constituir la base para la comprensión del lenguaje de signos y el control del gesto con la mano, y también puede permitir la superposición de contenido e información digital sobre el mundo físico en la realidad aumentada. La percepción robusta de las manos en tiempo real es una tarea de visión por computador muy difícil, ya que las manos a menudo se ocluyen a sí mismas o entre sí (por ejemplo, oclusiones de los dedos y las palmas y temblores de las manos) y carecen de patrones de alto contraste.

Hoy anunciamos el lanzamiento de un nuevo enfoque de la percepción de la mano, el cual se anticipó a CVPR 2019 en junio, implementado en MediaPipe, un marco de trabajo de plataforma cruzada de código abierto para la construcción de ductos para el procesamiento de datos perceptivos de diferentes modalidades, tales como video y audio. Este enfoque proporciona un seguimiento de alta fidelidad de la mano y los dedos mediante el empleo de aprendizaje automático (ML) para inferir 21 puntos clave 3D de una mano a partir de un solo fotograma. Mientras que los enfoques de vanguardia actuales se basan principalmente en entornos de escritorio potentes para la inferencia, nuestro método logra un rendimiento en tiempo real en un teléfono móvil, e incluso se escala a múltiples manos. Esperamos que el hecho de proporcionar esta funcionalidad de percepción de la mano a la comunidad de investigación y desarrollo en general dé lugar a la aparición de casos de uso creativo, estimulando nuevas aplicaciones y nuevas vías de investigación.

Una línea de ML para el seguimiento manual y el reconocimiento de gestos

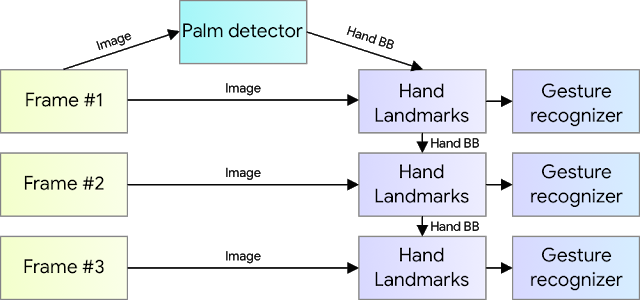

Nuestra solución de rastreo manual utiliza una tubería ML que consiste en varios modelos que trabajan juntos:

- Un modelo de detector de palma (llamado BlazePalm) que opera sobre la imagen completa y devuelve una caja orientada a mano.

- Un modelo que opera en la zona de la imagen recortada definida por el detector de palma y que devuelve puntos clave de mano 3D de alta fidelidad.

- Un reconocedor de gestos que clasifica la configuración de puntos clave previamente calculada en un conjunto discreto de gestos.

Esta arquitectura es similar a la empleada por nuestro recientemente publicado oleoducto de malla frontal ML y que otros han utilizado para la estimación de la pose. Proporcionar la imagen de palma recortada con precisión al modelo de punto de referencia de la mano reduce drásticamente la necesidad de aumentar los datos (por ejemplo, rotaciones, traslación y escala) y, en su lugar, permite que la red dedique la mayor parte de su capacidad a la precisión de la predicción de coordenadas.

BlazePalm: Detección manual y palmar en tiempo real

Para detectar la ubicación inicial de las manos, empleamos un modelo de detector de un solo disparo llamado BlazePalm, optimizado para usos móviles en tiempo real de manera similar a BlazeFace, que también está disponible en MediaPipe. La detección de manos es una tarea decididamente compleja: nuestro modelo tiene que trabajar con una variedad de tamaños de manos con un rango de escala grande (~20x) en relación con el marco de la imagen y ser capaz de detectar manos ocluidas y auto ocluidas. Mientras que los rostros tienen patrones de alto contraste, por ejemplo, en la región de los ojos y la boca, la falta de tales características en las manos hace comparativamente difícil detectarlos de manera confiable a partir de sus características visuales solamente. En su lugar, proporcionar un contexto adicional, como las características del brazo, del cuerpo o de la persona, ayuda a una localización precisa de las manos.

Nuestra solución aborda los retos anteriores utilizando diferentes estrategias. Primero, entrenamos un detector de palmas en lugar de un detector de manos, ya que estimar cajas delimitadoras de objetos rígidos como palmas y puños es significativamente más simple que detectar manos con dedos articulados. Además, como las palmas son objetos más pequeños, el algoritmo de supresión no máxima funciona bien incluso en los casos de autooclusión con dos manos, como los apretones de manos. Además, las palmas pueden ser modeladas usando cajas cuadradas delimitadoras (anclas en la terminología ML) ignorando otras relaciones de aspecto, y por lo tanto reduciendo el número de anclas por un factor de 3-5. En segundo lugar, se utiliza un extractor de funciones de codificador-decodificador para aumentar el conocimiento del contexto de la escena, incluso en el caso de objetos pequeños (similar al enfoque de RetinaNet). Por último, minimizamos la pérdida de foco durante el entrenamiento para soportar una gran cantidad de anclajes resultantes de la varianza de alta escala.

Con las técnicas anteriores, logramos una precisión media del 95,7% en la detección de palmas. Usando una pérdida regular de entropía cruzada y sin decodificador se obtiene una línea de base de sólo 86.22%.

Modelo Hand Landmark

Después de la detección de la palma de la mano en toda la imagen, nuestro modelo de punto de referencia de la mano posterior realiza una localización precisa de los puntos clave de 21 coordenadas 3D del mango dentro de las zonas de la mano detectadas mediante regresión, es decir, predicción directa de las coordenadas. El modelo aprende una representación consistente de la postura de la mano interna y es robusto incluso para las manos parcialmente visibles y las autooclusiones.

Para obtener datos de la verdad del terreno, hemos anotado manualmente ~30K imágenes del mundo real con 21 coordenadas 3D, como se muestra a continuación (tomamos el valor Z del mapa de profundidad de la imagen, si existe por coordenada correspondiente). Para cubrir mejor las posibles poses de la mano y proporcionar supervisión adicional sobre la naturaleza de la geometría de la mano, también renderizamos un modelo de mano sintético de alta calidad sobre varios fondos y lo mapeamos a las coordenadas 3D correspondientes.

Enlace Web - Fuente

CompuTekni

RSS:

¡Síguenos en Follow it y elige cómo quieres recibir nuestras noticias tecnológicas: por correo, estilo revista o periódico, RSS, Telegram, notificaciones del navegador o alertas móviles!.

Donativos:

¿Te gusta lo que hacemos?. Puedes apoyarnos con un donativo a través de: Buy Me a Coffee, Cripto, LiberaPay, Pagadito, PayPal. ¡Gracias por tu apoyo!.

Redes Sociales:

¡Conéctate con nosotros en: Bluesky, Mastodon, Threads, TikTok, WhatsApp Channel!.¡Síguenos para las últimas novedades en tecnología y noticias imperdibles!.

No hay comentarios.:

Publicar un comentario